To copilot τελικά το χρησιμοποιώ αποκλειστικά και μόνο όπου υπάρχει θέμα GDPR. Σε οτιδήποτε έχω δοκιμάσει σε σύγκριση με το chatgpt πάνω στο οποίο βασίζεται πάντα κάτι δεν μου πάει τόσο καλά ή περνάω περισσότερο χρόνο για να το φτιάξω. Είναι απίστευτοι δεινόσαυροι...να δω πως θα συμπεριφερθούν με τα μηνιαία update του ChatGPT. Προφανώς ακόμη τρέχει το 5.2.

Το σκ δοκίμασα το ChatGPT 5.4 σε κάποια πραγματάκια εκτός δουλειάς.

Λοιπόν πρώτα συμπεράσματα:

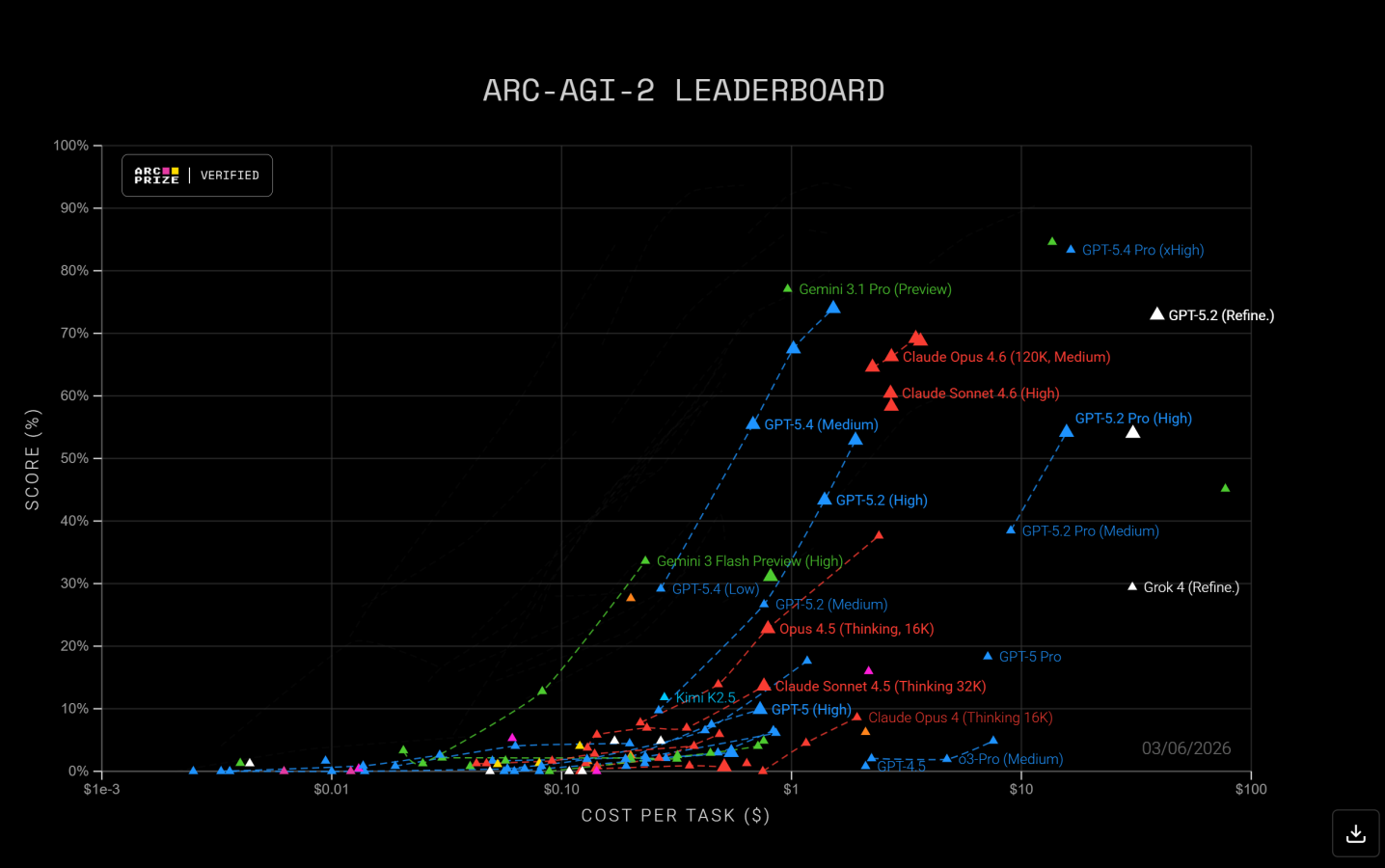

- To Auto έχει βελτιωθεί αρκετά και δουλεύει σχετικά σωστά. Ίσως αρχίσω να το χρησιμοποιώ για μικρά πράγματα που ως τώρα πήγαινα στο Gemini Pro 3.1 που έβγαζε πάντα απάντηση σε δευτερόλεπτα. Σε οτιδήποτε σχετικό με δουλειά μόνο thinking/xhigh γιατί άλλο η βελτίωση που είναι πραγματική και άλλο αν δουλεύει όντως πάντα σωστά.

- Η ενοποίηση στυλ Claude δουλεύει καλά. Ένα μοντέλο τα κάνει όλα και δεν είσαι υποχρεωμένος να πας στο Codex αν δεν απαιτείς συγκεκριμένη χρηστικότητα.

Λέω κάτσε να το δοκιμάσω με μερικά σενάρια από το σπίτι.

Α. Openclaw

Προφανώς με είχε βοηθήσει το 5.2 να το στήσω. Δούλευε όπως το ήθελα αν και όχι τέλεια. Είχε κάποια θεματάκια με την τροποποίηση των αρχείων Yaml αλλά πίστευα ότι ήταν κυρίως λόγω του μικρού μοντέλου 4Β που χρησιμοποιούσα. Του αντιγράφω το αρχείο skills, το Json του openclaw και του λέω τι παρατηρώ.

Σε ένα prompt μου βελτίωσε και τα 2 αρχεία και πρακτικά τέλος τα προβλήματα. Επίσης σκέφτηκε και υλοποίησε κάτι που μέχρι το 4.2 έπρεπε να το σκεφτώ εγώ, να το περιγράψω και να μου το υλοποιήσει. Με απλά λόγια όταν του λέω τώρα να κάνει delete κάποιο task δεν το κάνει delete, αλλά το κάνει flag ως ολοκληρωμένο, έγραψε μια ρουτίνα σε Python που την τρέχει 1 φορά την εβδομάδα και αυτή ντετερμινιστικά (και όχι μέσω llm) βρίσκει τα structured blocks που είναι ολοκληρωμένα και τα περνά σε δεύτερο Yaml για Backup αν γίνει κάποιο λάθος και τα αφαιρεί έτσι από το αρχικό μια φορά την εβδομάδα. Μια χαρά λέω.

Του λέω επίσης να μου φτιάξει ένα καινούργιο skill για notes taking αν και έχει ενσωματωμένο ώστε να γίνεται πιο δομημένα η αποθήκευση των Notes. Σε 2 μηνύματα έτοιμο και αυτό καλά.

Β. Wake from sleep

Ένα θέμα που έχω είναι ότι τρέχω το openclaw στο βασικό μου υπολογιστή, ένα λαπτοπ το οποίο μπαίνει σε sleep μετά από κάποια ώρα. Αυτό στο βασικό σενάριο χρήσης δεν έχει θέμα, αλλά αν θέλω να δω τα task μου από κινητό εκτός σπιτιού, πρακτικά δεν γίνεται. Και δεν θέλω να τον αφήνω ανοικτό συνέχεια.

Αυτό που είχα σκεφτεί ήταν να στήσω ένα Raspberry Pi να κάνει αποκλειστικά και μόνο αυτό. Να πηγαίνει ένα σήμα μέσω telegram στο Pi που θα είναι συνδεδεμένο με wifi στο Internet always on και μέσω ενός ethernet καλωδίου να ξυπνά το Laptop το οποίο και αυτό συνδέεται με wifi στο internet.

Μου το έφτυσε και αυτό σε ένα μήνυμα και μου άνοιξε η όρεξη. Κάποια προτζεκτάκια που είχα στο μυαλό μου ήταν:

- Να στήσω ένα Plex server σε ένα Pi αλλά να μην έχω ξεχωριστό storage εκεί, να έχει πρόσβαση στον δεύτερο σκληρό του λαπτοπ που έχω όλη τη μουσική βιβλιοθήκη μου μόνο με read only. Αυτό για να ακούω μουσική όταν τρέχω (που οκ το κάνω μέσω Spotify) ή για το Android Auto που πια λειτουργεί με φωνητικό search το NewPipe. Κοινώς περισσότερο για τη χαρά του project.

- Στον ίδιο ή σε άλλο Pi, Plex server να συνδέσω τo folder με όλο το φωτογραφικό μου αρχείο. Ναι υπάρχουν και καλύτερα λογισμικά, αλλά δεν το έψαξα και περισσότερο και έτσι και αλλιώς μιλάμε για χρήση 2-3 φορές το χρόνο από την android tv. Όλα από το 2019 και μετά είναι μόνιμα στο google photos έτσι και αλλιώς. Επίσης μόνο για τη χαρά του project.

- Έχω ένα εξωτερικό usb disk που κάνω χειροκίνητο Backup 1 φορά το μήνα/δίμηνο όποτε θυμηθώ τα πάντα (να πω ότι γίνονται backup σε πραγματικό χρόνο στο cloud). Είχα σκεφτεί να στήσω ένα raspbery που να το κάνει αυτό αυτοματοποιημένα. Εδώ ίσως έχει περισσότερο νόημα γιατί πραγματικά ξεχνάω να κάνω backup πολλές φορές.

Σε 5 περίπου γρήγορα μηνύματα είχε καταλάβει τι θέλω και μου είπε ότι άνετα μπορούσα να τα υλοποιήσω σε ένα και μόνο Pi και μάλιστα παλιό (3 B+). Και του λέω φτιάχτo, δώσε μου αναλυτικές οδηγίες βήμα βήμα from scratch και κάνε το με όποια καλύτερη λύση που να διασφαλίζει cybersecurity.

Και το έκανε...

Έκανε μερικά λαθάκια όπως το ότι μου έδωσε οδηγίες για dhcpcd, ενώ πια χρησιμοποιείται το NetworkManager, αλλά και αυτό ήταν απλά ένα εξτρά μήνυμα.

Μου πήρε μια ώρα και το μόνο που δεν έχω ενεργοποιήσει ακόμη είναι το αυτόματο backup...Όταν βρω κανένα μισάωρο θα το κάνω και αυτό. Η μισή δουλειά έχει γίνει πάντως και για αυτό όσο αφορά την πρόσβαση του Pi σε αυτά τα αρχεία.

Επίσης ενδιαφέρον, απλά του είπα να είναι το δυνατόν secure ότι προτείνει. Και στο τέλος των οδηγιών έγραψε ότι έχει ενσωματώσει στις οδηγίες τα παρακάτω:

- SSH keys only on the Pi; no password SSH

- PermitRootLogin no

- UFW enabled; expose only SSH and Plex

- dedicated Windows SMB account with read-only rights

- no full-drive sharing from Windows

- SMB mounts read-only on the Pi

- bot token stored only in .env with restrictive permissions

- Telegram bot restricted by user_id and chat_id

- Plex claimed to your account; authentication retained

- start Plex secure connections on Preferred; move to Required only after all your clients are verified

- disable DLNA unless required

- keep the Pi on automatic security updates

- rotate any compromised token or SMB password immediately

Νομίζω μια χαρά και για project στο σπίτι αν το έκανα μόνος μου σίγουρα αρκετά από τα παραπάνω δεν θα τα έκανα καθόλου.

Είναι απίστευτο το "απλά δουλεύει" που έχουμε φτάσει. Σκέφτομαι μόνο το wake on lan πως θα το έφτιαχνα κάποια χρόνια πριν με διάβασμα, κανένα guide, γράψιμο έστω και του λίγου κώδικα που απαιτείται που επειδή δεν είμαι προγραμματιστής θα μου έπαιρνε χρόνο...

Έχει ξεφύγει η κατάσταση...